k8s实战java程序

学习目标

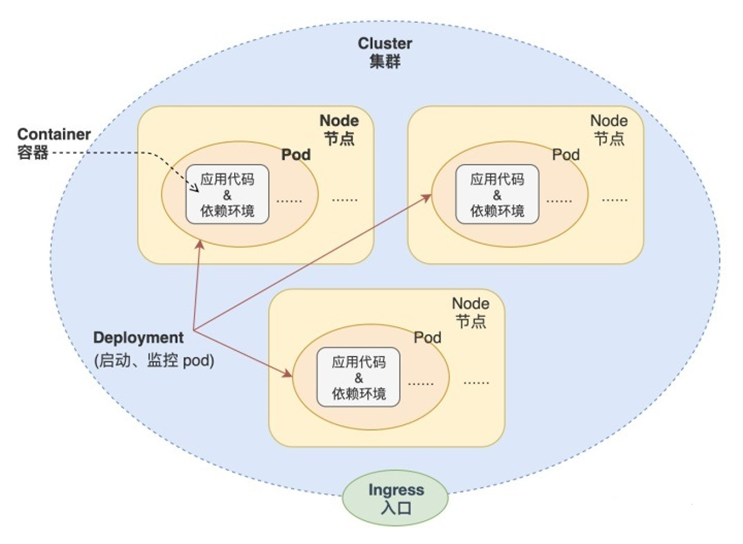

本章学习kubernetes的架构及工作流程,重点介绍如何使用Workload管理业务应用的生命周期,实现服务不中断的滚动更新,通过服务发现和集群内负载均衡来实现集群内部的服务间访问,并通过ingress实现外部使用域名访问集群内部的服务。

学习过程中会逐步对容器项目做k8s改造,从零开始编写所需的资源文件。通过本章的学习,学员会掌握高可用k8s集群的搭建,同时容器项目已经可以利用k8s的控制器、服务发现、负载均衡、配置管理等特性来实现生命周期的管理。

纯容器模式的问题

- 业务容器数量庞大,哪些容器部署在哪些节点,使用了哪些端口,如何记录、管理,需要登录到每台机器去管理?

- 跨主机通信,多个机器中的容器之间相互调用如何做,iptables规则手动维护?

- 跨主机容器间互相调用,配置如何写?写死固定IP+端口?

- 如何实现业务高可用?多个容器对外提供服务如何实现负载均衡?

- 容器的业务中断了,如何可以感知到,感知到以后,如何自动启动新的容器?

- 如何实现滚动升级保证业务的连续性?

- ......

容器管理平台

- Docker Swarm

- Mesos

- Google Kubernetes

2017年开始Kubernetes凭借强大的容器集群管理功能, 逐步占据市场,目前在容器编排领域一枝独秀

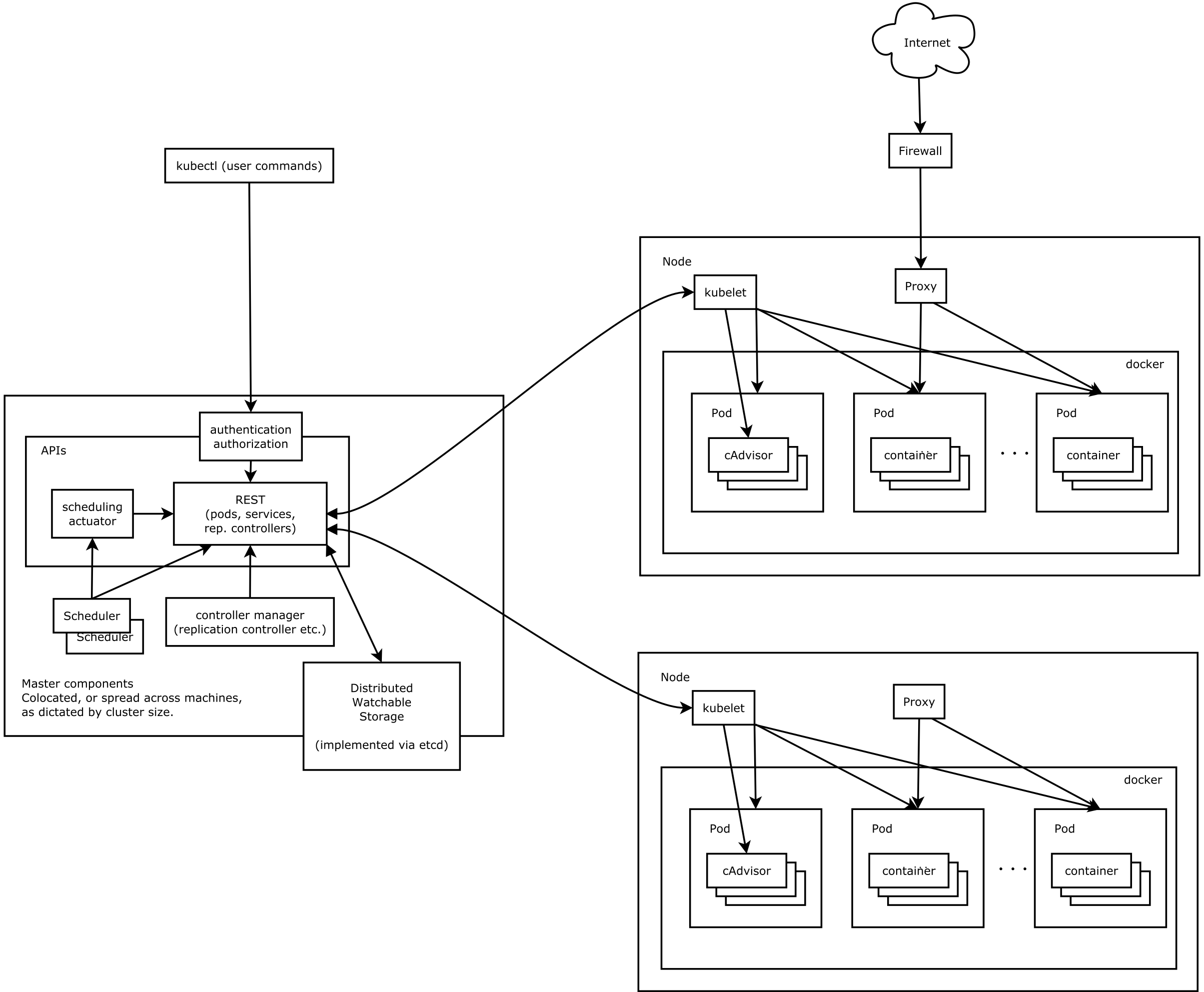

k8s组件架构

如何设计一个容器管理平台?

- 集群架构,管理节点分发容器到数据节点

- 如何部署业务容器到各数据节点

- N个数据节点,业务容器如何选择部署在最合理的节点

- 容器如何实现多副本,如何满足每个机器部署一个容器的模型

- 多副本如何实现集群内负载均衡

分布式系统,两类角色:管理节点和工作节点

k8s核心组件

- ETCD:分布式高性能键值数据库,存储整个集群的所有元数据

- ApiServer: API服务器,集群资源访问控制入口,提供restAPI及安全访问控制

- Scheduler:调度器,负责把业务容器调度到最合适的Node节点

- Controller Manager:控制器管理,确保集群资源按照期望的方式运行

- Replication Controller

- Node controller

- ResourceQuota Controller

- Namespace Controller

- ServiceAccount Controller

- Token Controller

- Service Controller

- Endpoints Controller

- kubelet:运行在每个节点上的主要的“节点代理”,脏活累活

- pod 管理:kubelet 定期从所监听的数据源获取节点上 pod/container 的期望状态(运行什么容器、运行的副本数量、网络或者存储如何配置等等),并调用对应的容器平台接口达到这个状态。

- 容器健康检查:kubelet 创建了容器之后还要查看容器是否正常运行,如果容器运行出错,就要根据 pod 设置的重启策略进行处理.

- 容器监控:kubelet 会监控所在节点的资源使用情况,并定时向 master 报告,资源使用数据都是通过 cAdvisor 获取的。知道整个集群所有节点的资源情况,对于 pod 的调度和正常运行至关重要

- kube-proxy:维护节点中的iptables或者ipvs规则

- kubectl: 命令行接口,用于对 Kubernetes 集群运行命令 https://kubernetes.io/zh/docs/reference/kubectl/

k8s组件如何运行?

- 二进制部署,基本以systemd形式去管理单个进程

- kubeadm启动k8s,组件部分用pod运行,部分是systemd管理。

什么是静态pod

Kubernetes(k8s)是一种流行的容器编排系统,用于在分布式环境中自动化应用程序的部署、扩展和管理。在 Kubernetes 中,有两种类型的 Pod:普通 Pod 和静态 Pod。

普通 Pod

普通 Pod 是 Kubernetes 集群中的标准 Pod。它们由 Kubernetes 控制器(如 Deployment、ReplicaSet 或 Job)动态创建和管理,通常用于长期运行的服务或批处理任务。这些 Pod 会在节点上分配动态 IP 地址,并且可以自动地重新调度到其他节点上。

静态 Pod

静态 Pod 是在 Kubernetes 节点上直接创建的 Pod,不受 Kubernetes 控制器的管理。它们是以 YAML 或 JSON 文件的形式定义的,并与具体的节点绑定在一起。每个节点上可以运行多个静态 Pod,它们通常用于短期的单次任务或基础设施组件。

需要注意的是,由于静态 Pod 不受 Kubernetes 控制器的管理,它们不能自动重新调度到其他节点上。因此,当节点失败或需要维护时,必须手动重新创建静态 Pod 或使用其他自动化工具来管理它们。

总之,普通 Pod 是由 Kubernetes 控制器创建和管理的,而静态 Pod 则是直接在节点上创建并绑定的。选择使用哪种类型的 Pod 取决于应用程序的具体需求。

静态Pod查看

## etcd、apiserver、controller-manager、kube-scheduler

[root@k8s-master ~]#kubectl -n kube-system get po

NAME READY STATUS RESTARTS AGE

coredns-74586cf9b6-k5mwm 1/1 Running 0 43h

coredns-74586cf9b6-xl4bc 1/1 Running 0 43h

etcd-k8s-master 1/1 Running 0 43h

kube-apiserver-k8s-master 1/1 Running 0 43h

kube-controller-manager-k8s-master 1/1 Running 0 43h

kube-proxy-6qbx5 1/1 Running 0 43h

kube-proxy-7m2cj 1/1 Running 0 43h

kube-proxy-glzmw 1/1 Running 0 43h

kube-scheduler-k8s-master 1/1 Running 0 43h

[root@k8s-master ~]#

systemd服务

$ systemctl status kubelet

kubectl:二进制命令行工具

作为客户端,通过证书,与k8s集群交互。

crictl读取容器socket

crictl依次查找容器运行时,当查找第一个 unix:///var/run/dockershim.sock 没有找到,所以报错了,需要你手动指定当前kubernetes的容器运行时,使用什么,例如:

kubernetes 1.24+ 之后,如果dockershim已经变成了cri-docker,所以你需要执行:

crictl config runtime-endpoint unix:///var/run/cri-dockerd.sock

如果你的容器运行时,已经换成了containerd,则换成containerd的,如:

crictl config runtime-endpoint unix:///var/run/containerd/containerd.sock

之后,你在执行就好了。

另外:生成的配置在cat /etc/crictl.yaml,可以随时修改。

正确用法

[root@k8s-slave1 ~]#crictl ps

CONTAINER IMAGE CREATED STATE NAME ATTEMPT POD ID POD

871252aa11f42 cc44224bfe208 4 minutes ago Running ngx1 0 492b0f2e95136 ngx1

4d8aa893ad626 cc44224bfe208 2 days ago Running test-nginx 0 846005acc3721 test-nginx

20c66bae7c3e1 0d004b381af6c 2 days ago Running kube-flannel 0 27491b4d2bda6 kube-flannel-ds-gs9dt

c287ac5dabf61 7a53d1e08ef58 2 days ago Running kube-proxy 0 6569afda43f6b kube-proxy-7m2cj

[root@k8s-slave1 ~]#

理解k8s集群资源

组件是为了支撑k8s平台的运行,安装好的软件。

资源是如何去使用k8s的能力的定义。比如,k8s可以使用Pod来管理业务应用,那么Pod就是k8s集群中的一类资源,集群中的所有资源可以提供如下方式查看:

# 如何查看k8s的组件,名字,缩写

# 这个命令查询即可

$ kubectl api-resources

如何理解namespace

命名空间,集群内一个虚拟的概念,类似于资源池的概念,一个池子里可以有各种资源类型,绝大多数的资源都必须属于某一个namespace。集群初始化安装好之后,会默认有如下几个namespace:

[root@k8s-master ~]#kubectl get namespaces

NAME STATUS AGE

default Active 44h

kube-flannel Active 43h

kube-node-lease Active 44h

kube-public Active 44h

kube-system Active 44h

kubernetes-dashboard Active 42h

- 所有NAMESPACED的资源,在创建的时候都需要指定namespace,若不指定,默认会在default命名空间下

- 相同namespace下的同类资源不可以重名,不同类型的资源可以重名

- 不同namespace下的同类资源可以重名

- 通常在项目使用的时候,我们会创建带有业务含义的namespace来做逻辑上的整合

kubectl学习

类似于docker,kubectl是命令行工具,用于与APIServer交互,内置了丰富的子命令,功能极其强大。

https://kubernetes.io/docs/reference/kubectl/overview/

$ kubectl -h

$ kubectl get -h

$ kubectl create -h

$ kubectl create namespace -h

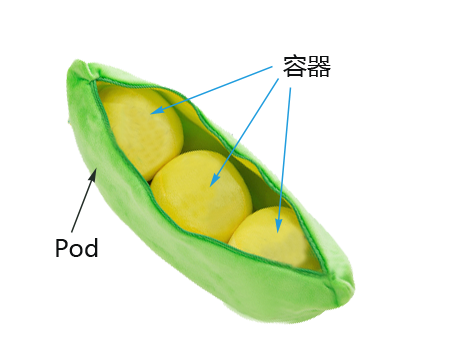

理解pod资源

docker调度的是容器,在k8s集群中,最小的调度单元是Pod(豆荚)

为什么用pod

与容器引擎解耦

Docker、Rkt。平台设计与引擎的具体的实现解耦

多容器共享网络|存储|进程 空间, 支持的业务场景更加灵活

pod怎么工作

实战pod改造java程序

前置环境(火坑)

原本我们是docker区部署java程序、现在改为pod运行试试。

前提是你得有该系列镜像,参考之前的docker教程。

[root@training-linux ~/eladmin]#curl -u admin:admin -X GET http://10.0.0.66:5000/v2/_catalog

{"repositories":["eladmin/eladmin-api"]}

docker run -d -p 3306:3306 --name mysql -v /opt/mysql:/var/lib/mysql -e MYSQL_DATABASE=eladmin -e MYSQL_ROOT_PASSWORD=www.yuchaoit.cn mysql:5.7 --character-set-server=utf8mb4 --collation-server=utf8mb4_unicode_ci

docker run -p 6379:6379 -d --name redis --restart=always redis:3.2 redis-server

[root@training-linux ~/eladmin/sql]#docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

ea36dacd7456 redis:3.2 "docker-entrypoint.s…" Less than a second ago Up Less than a second 0.0.0.0:6379->6379/tcp, :::6379->6379/tcp redis

6e538d8769c7 mysql:5.7 "docker-entrypoint.s…" Less than a second ago Up Less than a second 0.0.0.0:3306->3306/tcp, :::3306->3306/tcp, 33060/tcp mysql

c5e7dd973e6e registry "/entrypoint.sh /etc…" Less than a second ago Up Less than a second 0.0.0.0:5000->5000/tcp, :::5000->5000/tcp registry

[root@training-linux ~/eladmin/sql]#

于超老师这里是准备了一个docker服务器,提供镜像与DB等。

具体yaml实战

理解yaml,与json转化,http://www.wetools.com/yaml/

pod-eladmin-api.yaml

apiVersion: v1

kind: Pod

metadata:

name: eladmin-api

namespace: yuchao

labels:

app: eladmin-api

spec:

containers:

- name: eladmin-api

image: 10.0.0.66:5000/eladmin/eladmin-api:v1

env:

- name: DB_HOST # 指定数据库地址

value: "10.0.0.66"

- name: DB_USER # 指定数据库连接使用的用户

value: "root"

- name: DB_PWD

value: "www.yuchaoit.cn"

- name: REDIS_HOST

value: "10.0.0.66"

- name: REDIS_PORT

value: "6379"

ports:

- containerPort: 8000 # 同EXPOSE,声明业务端口号

yaml版本理解

| apiVersion | 含义 |

|---|---|

| alpha | 进入K8s功能的早期候选版本,可能包含Bug,最终不一定进入K8s |

| beta | 已经过测试的版本,最终会进入K8s,但功能、对象定义可能会发生变更。 |

| stable | 可安全使用的稳定版本 |

| v1 | stable 版本之后的首个版本,包含了更多的核心对象 |

| apps/v1 | 使用最广泛的版本,像Deployment、ReplicaSets都已进入该版本 |

支持的资源类型与apiVersion

kubectl api-resources

快速获得资源和版本

$ kubectl explain pod

$ kubectl explain Pod.apiVersion

创建与访问pod(火坑)

这里难点在于,k8s集群,如果使用企业内网的私有镜像,以及存在账号密码,就得处理2个问题

- https问题

- 镜像拉取策略,加入账号密码问题

## 创建namespace, namespace是逻辑上的资源池

kubectl create namespace yuchao

## 使用指定文件创建Pod

kubectl create -f pod-eladmin-api.yaml

## 上述操作会出现ImagePullBackOff,创建镜像拉取所用的密钥信息

# 这一步是重中之重

# 并且确保所有节点,是配置好了,允许访问私有仓库的

# --docker-server=10.0.0.66:5000 不要携带http

kubectl -n yuchao create secret docker-registry registry-10.0.0.66 --docker-username=admin --docker-password=admin --docker-email=yc_uuu@163.com --docker-server=10.0.0.66:5000

## 给pod配置上述密钥

apiVersion: v1

kind: Pod

metadata:

name: eladmin-api

namespace: yuchao

labels:

app: eladmin-api

spec:

imagePullSecrets:

- name: registry-10.0.0.66

containers:

- name: eladmin-api

...

## 删除pod重建,两种方式

kubectl -n yuchao delete pod eladmin-api

kubectl delete -f pod-eladmin-api.yaml

## 查看pod,可以简写po

## 所有的操作都需要指定namespace,如果是在default命名空间下,则可以省略

[root@k8s-master ~/k8s-all]#kubectl -n yuchao get po -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

eladmin-api 1/1 Running 0 6s 10.244.2.7 k8s-slave1 <none> <none>

## 回顾流程

## 使用Pod Ip访问服务

[root@k8s-master ~/k8s-all]#curl 10.244.2.7:8000/auth/code

## 进入容器,执行初始化, 不必到对应的主机执行docker exec

# 通过kubectl exec即可远程操作pod

[root@k8s-master ~/k8s-all]# kubectl -n yuchao exec -ti eladmin-api bash

kubectl exec [POD] [COMMAND] is DEPRECATED and will be removed in a future version. Use kubectl exec [POD] -- [COMMAND] instead.

root@eladmin-api:/opt/eladmin#

root@eladmin-api:/opt/eladmin#

root@eladmin-api:/opt/eladmin# ps -ef

UID PID PPID C STIME TTY TIME CMD

root 1 0 0 17:25 ? 00:00:00 sh -c java -Dspring.profiles.active=prod -jar eladmin-system-2.6.jar

root 7 1 11 17:25 ? 00:00:16 java -Dspring.profiles.active=prod -jar eladmin-system-2.6.jar

root 60 0 0 17:28 pts/0 00:00:00 bash

root 65 60 0 17:28 pts/0 00:00:00 ps -ef

root@eladmin-api:/opt/eladmin#

# 查看后端容器环境变量

root@eladmin-api:/opt/eladmin# env

DB_HOST=10.0.0.66

HOSTNAME=eladmin-api

TERM=xterm

KUBERNETES_PORT_443_TCP_PORT=443

KUBERNETES_PORT=tcp://10.96.0.1:443

KUBERNETES_SERVICE_PORT=443

KUBERNETES_SERVICE_HOST=10.96.0.1

CA_CERTIFICATES_JAVA_VERSION=20140324

REDIS_HOST=10.0.0.66

PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin

PWD=/opt/eladmin

JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

LANG=C.UTF-8

JAVA_VERSION=8u111

DB_PWD=www.yuchaoit.cn

SHLVL=1

HOME=/root

REDIS_PORT=6379

JAVA_DEBIAN_VERSION=8u111-b14-2~bpo8+1

KUBERNETES_PORT_443_TCP_PROTO=tcp

KUBERNETES_SERVICE_PORT_HTTPS=443

DB_USER=root

KUBERNETES_PORT_443_TCP_ADDR=10.96.0.1

KUBERNETES_PORT_443_TCP=tcp://10.96.0.1:443

_=/usr/bin/env

root@eladmin-api:/opt/eladmin#

查看pod所在节点的images

[root@k8s-slave1 ~]#crictl images

IMAGE TAG IMAGE ID SIZE

10.0.0.66:5000/eladmin/eladmin-api v1 8875c67d330d7 365MB

docker.io/flannel/flannel-cni-plugin v1.1.2 7a2dcab94698c 3.84MB

docker.io/flannel/flannel v0.21.3 0d004b381af6c 24.2MB

docker.io/library/nginx alpine cc44224bfe208 10.2MB

registry.aliyuncs.com/google_containers/kube-proxy v1.24.4 7a53d1e08ef58 39.5MB

registry.aliyuncs.com/google_containers/pause 3.6 6270bb605e12e 302kB

建议用nerdctl

[root@k8s-slave1 ~]#nerdctl -n k8s.io images

REPOSITORY TAG IMAGE ID CREATED PLATFORM SIZE BLOB SIZE

10.0.0.66:5000/eladmin/eladmin-api v1 a5227dad3ebd 22 hours ago linux/amd64 776.9 MiB 347.8 MiB

flannel/flannel-cni-plugin v1.1.2 bf4b62b13166 2 days ago linux/amd64 7.9 MiB 3.7 MiB

flannel/flannel v0.21.3 2947963f52c2 2 days ago linux/amd64 63.0 MiB 23.1 MiB

nginx alpine eb05700fe7ba 2 days ago linux/amd64 25.2 MiB 9.7 MiB

registry.aliyuncs.com/google_containers/kube-proxy v1.24.4 64a04a34b31f 2 days ago linux/amd64 110.1 MiB 37.7 MiB

registry.aliyuncs.com/google_containers/pause 3.6 3d380ca88645 2 days ago linux/amd64 668.0 KiB 294.7 KiB

[root@k8s-slave1 ~]#

查看Infra容器

- 后端启动了2个容器

- 其中包含eladmin容器以及pause容器

- 原因是k8s为了实现Pod内部的容器可以通过localhost通信,每个Pod都会启动pause容器,然后Pod内部的其他容器的网络空间会共享该pause容器的网络空间(Docker网络的container模式),pause容器只需要hang住网络空间,不需要额外的功能,因此资源消耗极低。

[root@k8s-slave1 ~]#nerdctl -n k8s.io ps -a|grep eladmin-api

ad006d88b2d2 registry.aliyuncs.com/google_containers/pause:3.6 "/pause" 22 hours ago Up k8s://yuchao/eladmin-api

ebb7694e24aa 10.0.0.66:5000/eladmin/eladmin-api:v1 "sh -c java -Dspring…" 22 hours ago Up k8s://yuchao/eladmin-api/eladmin-api

[root@k8s-slave1 ~]#

$ crictl -r "unix:///var/run/containerd/containerd.sock" pull 10.0.0.66:5000/eladmin/eladmin-api:v1

$ crictl -r "unix:///var/run/containerd/containerd.sock" rmi xxxxx

$ nerdctl pull 10.0.0.66:5000/eladmin/eladmin-api:v1

$ crictl -r "unix:///var/run/containerd/containerd.sock" logs -f 5627a65b98416

查看container容器日志

新版本k8s,只能通过crictl去查看k8s部署pod的运行日志

[root@k8s-slave1 ~]#crictl ps

CONTAINER IMAGE CREATED STATE NAME ATTEMPT POD ID POD

ebb7694e24aae 8875c67d330d7 22 hours ago Running eladmin-api 0 ad006d88b2d27 eladmin-api

[root@k8s-slave1 ~]#crictl logs -f ebb7694e24aa

查看pod详细信息

# 查看pod调度到哪,以及pod的ip

[root@k8s-master ~/k8s-all]#kubectl -n yuchao get pods -owide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

eladmin-api 1/1 Running 0 21h 10.244.2.7 k8s-slave1 <none> <none>

# 查看pod应用,导出的yaml详细

[root@k8s-master ~/k8s-all]#kubectl -n yuchao get pods eladmin-api -oyaml

# 查看pod运行发生了什么

[root@k8s-master ~/k8s-all]#kubectl -n yuchao describe pod eladmin-api

pod排错思路

#进入Pod内的容器

$ kubectl -n <namespace> exec <pod_name> -c <container_name> -ti /bin/sh

#查看Pod内容器日志,显示标准或者错误输出日志

$ kubectl -n <namespace> logs -f <pod_name> -c <container_name>

更新pod

更新后端>更新pod>更新yaml

$ kubectl apply -f pod-eladmin-api.yaml

删除pod

#根据文件删除

$ kubectl delete -f pod-eladmin-api.yaml

#根据pod_name删除

$ kubectl -n <namespace> delete pod <pod_name>

pod多容器

一个服务yaml里可以写入多个容器的运行

apiVersion: v1

kind: Pod

metadata:

name: eladmin

namespace: yuchao

labels:

app: eladmin

spec:

imagePullSecrets:

- name: registry-10.0.0.66

containers:

- name: eladmin-api

image: 10.0.0.66:5000/eladmin/eladmin-api:v1

env:

- name: DB_HOST # 指定数据库地址

value: "10.0.0.66"

- name: DB_USER # 指定数据库连接使用的用户

value: "root"

- name: DB_PWD

value: "www.yuchaoit.cn"

- name: REDIS_HOST

value: "10.0.0.66"

- name: REDIS_PORT

value: "6379"

ports:

- containerPort: 8000

- name: eladmin-web

image: 10.0.0.66:5000/eladmin/eladmin-web:v1

ports:

- containerPort: 80

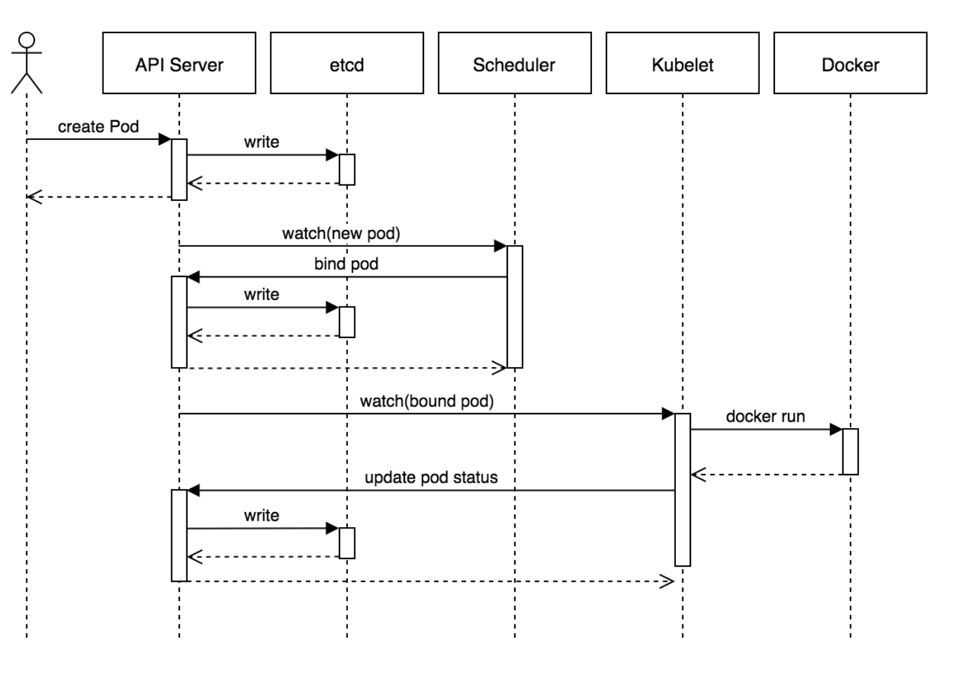

k8s组件工作流程

- 用户准备一个资源文件(记录了业务应用的名称、镜像地址等信息),通过调用APIServer执行创建Pod

- APIServer收到用户的Pod创建请求,将Pod信息写入到etcd中

- 调度器通过list-watch的方式,发现有新的pod数据,但是这个pod还没有绑定到某一个节点中

- 调度器通过调度算法,计算出最适合该pod运行的节点,并调用APIServer,把信息更新到etcd中

- kubelet同样通过list-watch方式,发现有新的pod调度到本机的节点了,因此调用容器运行时,去根据pod的描述信息,拉取镜像,启动容器,同时生成事件信息

- 同时,把容器的信息、事件及状态也通过APIServer写入到etcd中

k8s架构思考

- 系统各个组件分工明确(APIServer是所有请求入口,CM是控制中枢,Scheduler主管调度,而Kubelet负责运行),配合流畅,整个运行机制一气呵成。

- 除了配置管理和持久化组件ETCD,其他组件并不保存数据。意味

除ETCD外其他组件都是无状态的。因此从架构设计上对kubernetes系统高可用部署提供了支撑。 - 同时因为组件无状态,组件的升级,重启,故障等并不影响集群最终状态,只要组件恢复后就可以从中断处继续运行。

- 各个组件和kube-apiserver之间的数据推送都是通过list-watch机制来实现。